Qué es un Filtro Pasabajos y cómo funciona?

La mayoría de las cámaras digitales de los años 2000 y 2010 están equipadas con un elemento óptico llamado filtro de paso bajo óptico (OLPF), también conocido como filtro de anti-aliasing (AA) o filtro de desenfoque. Como sugiere el nombre “filtro”, este elemento óptico filtra parte de la información proveniente de la escena capturada. A diferencia de un filtro infrarrojo, un filtro de paso bajo actúa sobre la información espacial de alta frecuencia, mientras que un filtro infrarrojo elimina la información espectral. En pocas palabras, el filtro óptico de paso bajo borra ligeramente la imagen antes de llegar al sensor de silicio. En una era en la que las reseñas de cámaras se centran en la resolución de imagen y el recuento de megapíxeles, esto puede parecer paradójico.

En este artículo, explicaremos por qué eliminar las frecuencias espaciales más altas podría ser de interés para un fotógrafo, cómo lo hace el filtro paso bajo óptico y por qué la mayoría de las cámaras modernas ya no los utilizan.

Tabla de contenidos

- Filtros de paso bajo en cámaras digitales

- Frecuencias Espaciales 101

- Filtrando los artefactos de Moiré.

- ¿Cómo se fabrican los filtros de paso bajo ópticos?

- Por qué los filtros de paso bajo están desapareciendo de las cámaras

Filtros paso bajo en cámaras digitales

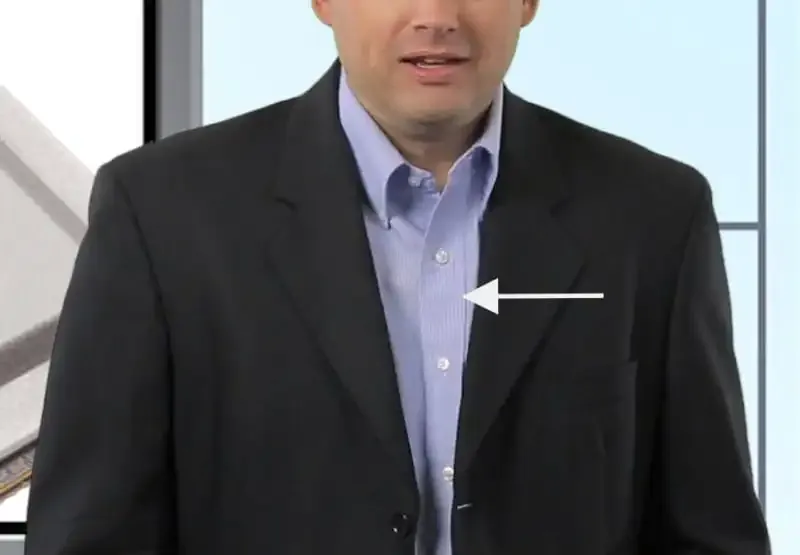

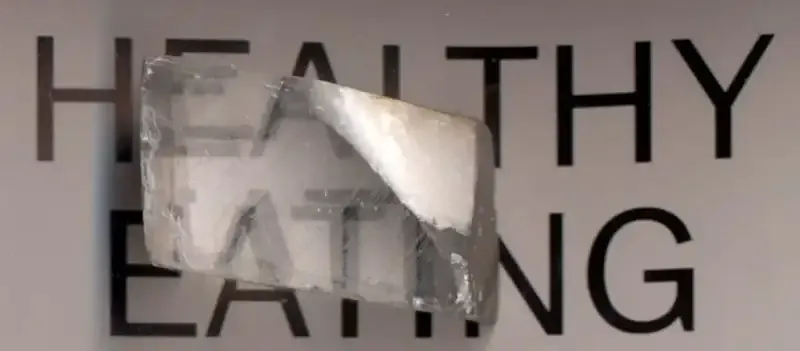

Si alguna vez has fotografiado una escena u objeto con ciertos tejidos y/o un patrón en forma de rejilla, es posible que hayas notado que la foto resultante contiene un efecto no deseado (posiblemente de colores arcoíris) en esas áreas.

El efecto colorido puede resultar frecuentemente al fotografiar ciertos tipos de prendas y/o telas.

Este efecto se debe a patrones moiré y colores falsos, y ocurre cuando las líneas o patrones repetitivos exceden la resolución del sensor de imagen.

Para combatir los patrones de moiré no deseados y el falso color en las fotos, los fabricantes de cámaras diseñaron filtros ópticos de paso bajo y los colocaron sobre los sensores de imagen. Esta característica de la cámara puede reducir o eliminar considerablemente la interferencia de moiré en las fotos.

Al difuminar ligeramente los detalles ultrafinos de una escena, los filtros de paso bajo se volvieron omnipresentes en las cámaras digitales como la solución al efecto moiré.

Esta táctica tiene un intercambio, sin embargo: el precio por tener menos moiré es una ligeramente menor nitidez. Para la gran mayoría de fotógrafos, especialmente aquellos que utilizan sus cámaras para capturar momentos cotidianos, la diferencia en nitidez es imperceptible, por lo que incluir un filtro de paso bajo es una decisión obvia.

Sin embargo, para algunos fotógrafos que necesitan el máximo nivel de nitidez en sus fotos, como los fotógrafos de paisajes y astrofotógrafos, el desenfoque introducido por un filtro paso bajo puede ser indeseable. Los patrones de Moiré casi siempre se encuentran en cosas hechas por el hombre, por lo que aquellos que fotografían la naturaleza en el suelo o en el cielo típicamente no necesitan un filtro paso bajo. Estos fotógrafos pueden optar por comprar una cámara que no incluya el filtro paso bajo o pueden modificar sus cámaras para eliminar el filtro delante del sensor.

Muchas de las últimas cámaras digitales en la industria también prescinden del filtro de paso bajo a favor de una mayor nitidez, pero más sobre eso más tarde.

Frecuencias espaciales 101

Ahora que comprendes los conceptos básicos de alto nivel de los filtros paso bajo y los patrones de moiré, vamos a adentrarnos más en la ciencia que hay detrás de cómo funciona todo.

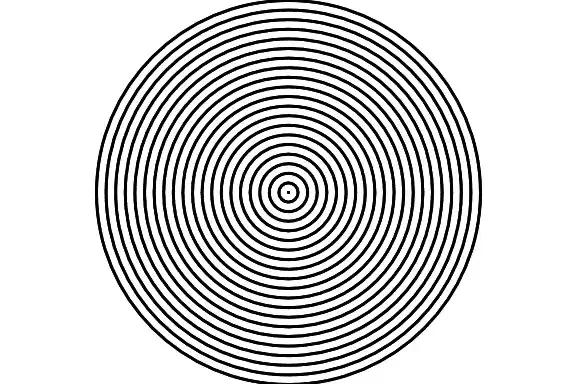

Antes de que podamos entender por qué deberíamos usar algún tipo de filtro de resolución espacial en el sensor de la cámara, primero expliquemos algunos conceptos básicos relacionados con el procesamiento de señales. Fundamentalmente, una imagen 2D puede descomponerse en una suma de ondas sinusoidales con diferentes amplitudes y frecuencias.

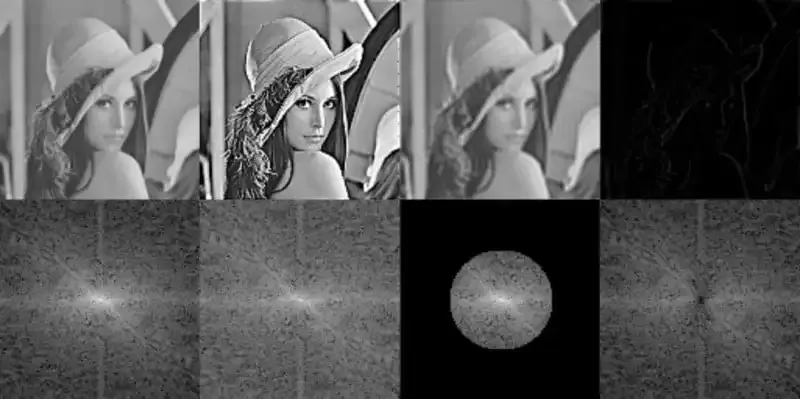

Aunque una prueba matemática de ello estaría mucho más allá del alcance de este artículo, esta propiedad se utiliza en muchos algoritmos de procesamiento de imágenes o formatos de compresión de imágenes. Para tener una idea del contenido de frecuencia de una imagen, se puede calcular una transformada de Fourier de ella, utilizando el algoritmo 2D-FFT.

Es posible probar este algoritmo en línea con tus propias imágenes. El centro de cualquier transformada de Fourier 2D abarca las bajas frecuencias espaciales de la imagen, mientras que los bordes contienen las altas frecuencias espaciales, es decir, los detalles finos de la imagen.

Desde un punto de vista matemático, tomar una fotografía perfecta requiere una estimación adecuada de todas las frecuencias espaciales de la escena del objeto. En la práctica, lo peor que podría suceder al contenido de la imagen es que se pierdan algunas frecuencias espaciales o se registren con información incorrecta a través del proceso de imagen.

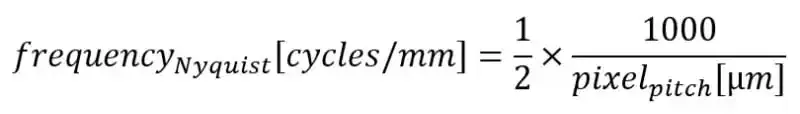

Dado que la resolución de la imagen es finita, existe por definición una frecuencia espacial máxima que se puede registrar, la cual está relacionada con el sensor. Esta es conocida como la “frecuencia Nyquist” del sensor. Cualquier frecuencia espacial por encima de esta frecuencia máxima simplemente no se puede registrar, de la misma manera en que no se pueden contar 30 con solo 10 dedos. La estimación de esta frecuencia espacial más alta registrada depende del teorema de muestreo Nyquist-Shannon. Este teorema establece que para una frecuencia dada f (en ciclos/mm), se necesitan adquirir al menos el doble de puntos por ciclo. Una fórmula directa debería lucir así:

Cuando esté disponible, esta fórmula se enriquece aún más con información sobre la forma del píxel y la pantalla a través del factor Kell. La frecuencia espacial de Nyquist de la mayoría de los sensores suele estar alrededor de 100 ciclos/mm.

Filtrando los artefactos de Moiré

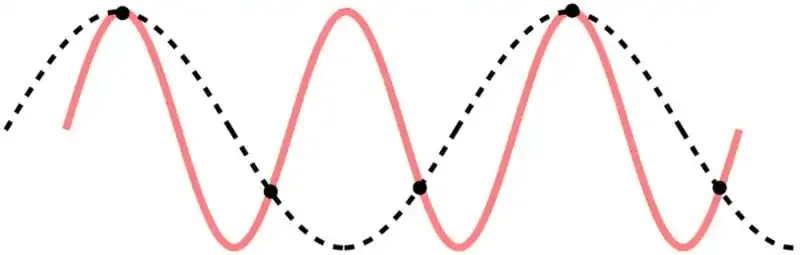

Ahora que hemos establecido la frecuencia espacial máxima teórica de un sensor de imagen, surge una nueva pregunta: ¿qué sucede con todas las frecuencias espaciales más altas?

Estas frecuencias espaciales más altas no simplemente desaparecen durante el proceso de imagen, se registran incorrectamente debido al bajo número de muestras disponibles. Ya que no pueden ser registradas con la frecuencia alta correcta, son registradas incorrectamente con una frecuencia espacial mucho más baja. Este efecto es conocido como aliasing o patrones moiré.

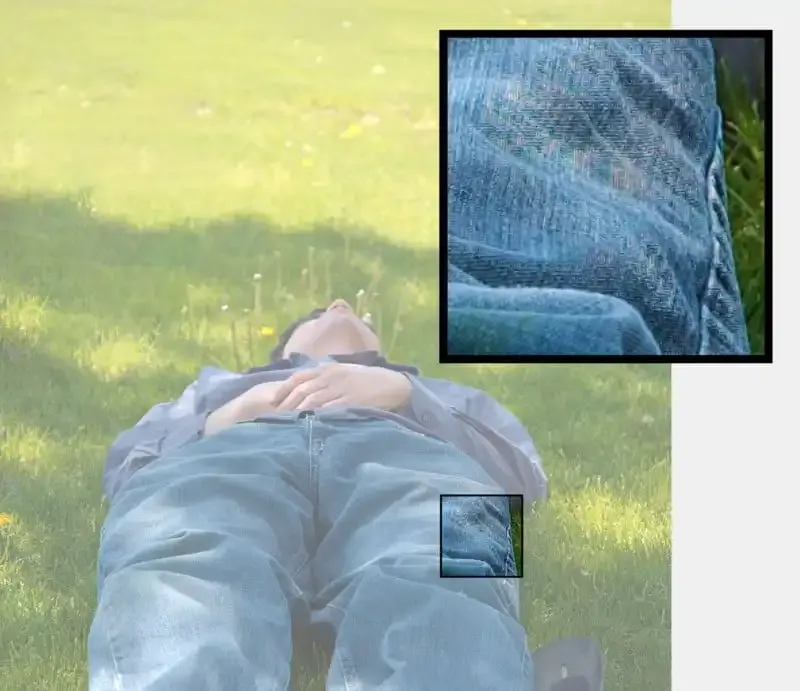

Puede ser interesante destacar que esta propiedad de los patrones de moiré se puede ver en las cartas de prueba (cartas Imatest, por ejemplo). En tales cartas de prueba, cualquier frecuencia espacial por encima de la resolución máxima del sistema resultará en un desenfoque gris simple o patrones de moiré (generalmente líneas diagonales).

No hace falta decir que los patrones moiré son impredecibles y lejos de ser visualmente agradables. Además, tienden a ser bastante difíciles de corregir mediante algoritmos. Incluso los algoritmos de última generación que utilizan redes neuronales a menudo fracasan con imágenes de la vida real, ya que los patrones moiré suelen presentar artefactos de color. Estos artefactos de color aparecen porque el patrón moiré puede ser diferente para los canales rojo, verde y azul registrados por la cámara.

¿Cómo se fabrican los filtros de paso bajo ópticos?

Para evitar los diversos artefactos y patrones de moiré mencionados anteriormente, los ingenieros han intentado ajustar la resolución óptica del sistema para que coincida con el sensor. Si el sistema óptico limita la resolución en lugar del sensor, las frecuencias más altas se difuminan y no crean artefactos en la imagen final.

Un problema muy práctico viene con esta idea de una lente con resolución voluntariamente limitada. Esto significa técnicamente que cada lente debe adaptarse a una resolución de sensor específica. En sistemas de lentes fijas, como las cámaras de teléfonos inteligentes, esto se logra fácilmente. Sin embargo, en cámaras réflex digitales (DSLR) o sistemas sin espejo, las lentes deben ser compatibles con varias generaciones de sensores. Los filtros de paso bajo ópticos encuentran una solución elegante al problema. Usando un delgado filtro óptico colocado directamente en el sensor, uno puede ajustar prácticamente cualquier lente para que coincida con la resolución del sensor.

Sin embargo, difuminar la imagen con la cantidad deseada de desenfoque es un desafío técnico. Idealmente, se desearía que el filtro fuera uniforme en todo el sensor (invariante de campo), consistente independientemente de la longitud focal (invariante del ángulo del rayo principal) y uniforme para todos los colores (invariante del color).

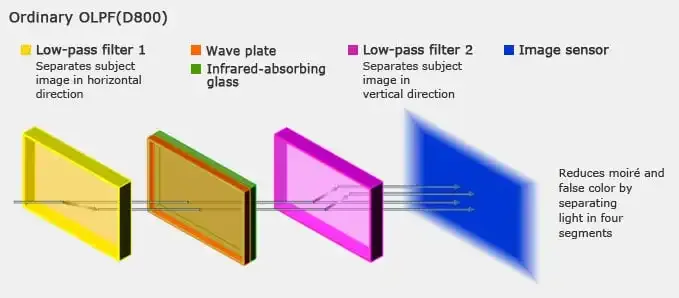

La tecnología más común utilizada para construir filtros pasa bajas se basa en la birrefringencia, más comúnmente con el uso de cuarzo birrefringente. Según Wikipedia: “La birrefringencia es la propiedad óptica de un material que tiene un índice de refracción que depende de la polarización y la dirección de propagación de la luz”. Para simplificarlo aún más, en este tipo de materiales, la trayectoria de la luz difiere según la polarización de la luz.

Dado que la luz visible está compuesta al menos por luz polarizada vertical y horizontalmente, después de viajar a través de un material birrefringente se producen dos imágenes ligeramente desplazadas. Luego, el proceso se repite capa tras capa de material birrefringente para producir imágenes desplazadas adicionales. Un filtro típico de una cámara réflex digital contiene dos capas de material birrefringente.

Por qué los filtros paso-bajo están desapareciendo de las cámaras

Desde la década de 2010, los filtros ópticos de paso bajo se han eliminado de las DSLR. La tendencia de eliminación comenzó con la Nikon D800 lanzada en 2012. Esta cámara insignia de Nikon se vendía tanto con como sin un filtro de paso bajo óptico (como las variantes Nikon D800 y Nikon D800E), asumiendo que los fotógrafos elegirían la cámara más adecuada para sus necesidades. En la vida real, los revisores encontraron la diferencia sutil en la mayoría de las situaciones.

Quitar el filtro de paso bajo tiene tres razones principales, según los fabricantes. Primero, la resolución del sensor ha aumentado drásticamente desde las primeras cámaras digitales, lo que permite que se registre información de frecuencia más alta.

En segundo lugar, como se mencionó anteriormente, la información de alta frecuencia es muy rara en la naturaleza, lo que significa que el riesgo de tener moiré en una imagen tiende a disminuir a medida que aumenta la resolución de la imagen.

Tercero, el procesamiento digital de imágenes ha mejorado y puede corregir imágenes si es necesario.

Tal vez un cambio aún más grande explica la falta de filtros de paso bajo. A diferencia de los años 2000, los lentes son cada vez más el factor limitante cuando se trata de resolución, en lugar de los sensores. Encontrar un lente que supere a un sensor de 50MPx es bastante difícil, incluso con un presupuesto ilimitado. En la práctica, esto significa que la mayoría de los lentes actúan como filtros de paso bajo ópticos por sí mismos.

Todavía hay una gran comunidad que requiere filtros de paso bajo: la comunidad de video. Aunque la resolución de video ha aumentado de 720p a 4K en la última década, los artefactos de moiré todavía son bastante comunes y los filtros de paso bajo juegan un papel. Después de todo, 4K todavía es alrededor de 8 megapíxeles, que está cerca de la resolución de imágenes fijas de finales de la década de 2000. Las cámaras RED, por ejemplo, ofrecen un OLPF físico o una corrección digital. Hasta que el video de 8K se convierta en la norma, los filtros de paso bajo ópticos o al menos los “filtros de brillo” deberían seguir siendo útiles para los videógrafos.

Sobre el autor: Timothee Cognard es un experto en óptica y fotógrafo radicado en París, Francia.

Créditos de la imagen: Ilustración del encabezado hecha con una foto de Phiarc y con licencia CC BY-SA 4.0.

Contenido Relacionado